史上最强AI?马斯克20万块GPU烧出的是史上能耗最高大模型

Grok 3是否为地表最强AI存在争议,但其能耗确实达到了前所未有的水平。训练过程中消耗的能源相当于一座小城市一年的用电量或4万多辆燃油车一年的碳排放量。Grok 3的诞生揭示了它仍未摆脱以能耗换性能的传统“规模扩展”模式,在全行业开源之风渐浓、越来越推崇性价比的情况下,如何在优化模型效率与降低能耗之间达到平衡成为亟需解决的问题。

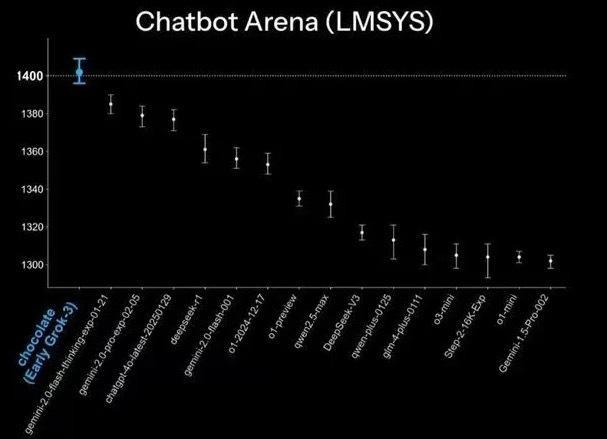

2月18日,马斯克在X平台直播发布Grok 3,并进行了现场演示。PPT显示,Grok 3在AIME’24数学能力测试、GPQA科学知识评估、LCB Oct – Feb编程能力测试等多项测试中击败了谷歌Gemini 2 Pro、DeepSeek V3、Anthropic的Claude 3.5 sonnet和OpenAI的GPT-4o。在Chatbot Arena LLM排行榜上,代号巧克力的Grok 3早期版本登上榜首,成为有史以来第一个突破1400分的模型,不过这一分数仅比DeepSeek R1高2.9%。柱状图之所以显得差距显著,是因为图片是从1300分开始截图,自带“放大”效果。

事实上,直播中也出现了一些问题,比如马斯克用Grok 3演示飞向火星代码时,输出两次失败,最终第三次才成功。直播后,部分用户测试了最新的Beta版Grok 3,发现它在回答经典问题“9.11与9.9哪个大”时答错了。考虑到Grok 2发布时虽然轰动,但实际使用效果不佳,Grok 3是否会重蹈覆辙尚不清楚。目前可以肯定的是,这款被马斯克称为“地球上最聪明的AI”依赖于算力堆叠,背后的训练成本极其庞大。

马斯克透露,Grok 3的训练量是Grok 2的10倍,基于xAI位于孟菲斯的超级计算机集群进行。该集群第一阶段拥有10万块NVIDIA H100 GPU,第二阶段扩展到20万块GPU。有人计算,仅10万块H100 GPU的成本就已超过30亿美元。相比之下,6710亿参数的DeepSeek V3在配备2048块英伟达H800 GPU集群上训练,总成本仅为557.6万美元。Grok 3的算力消耗约为DeepSeek V3的263倍,尽管前者在数学推理和编程能力上表现更优异,但这显示出两者在资源使用上的巨大差异。Grok 3使用的GPU总能耗相当于一个小城市的用电量,产生的碳排放大致相当于4万多辆燃油车一年的碳排放量。

相关推荐:

- 2025-03-04

- 2025-03-04

- 2025-03-04